informatique

(de information et automatique)

Science du traitement automatique et rationnel de l'information considérée comme le support des connaissances et des communications.

L'informatique est au centre d'un secteur industriel dont les produits ont évolué avec une rapidité fulgurante. Elle apparaît tour à tour accusée de tous les maux ou auréolée de tous les pouvoirs. De machine à rêver, l'ordinateur est devenu un outil qui a investi tant la vie privée que le monde professionnel. Cette évolution technologique a transformé au fur et à mesure ses méthodes d'utilisation et provoqué une diversification du paysage informatique.

1. La science de l'information

Le terme « informatique », qui désigne une discipline née avec l'ordinateur, est un néologisme français, introduit en 1962 par Philippe Dreyfus, condensant les mots information et automatique. Les Anglo-Saxons parlent de computer science et de data processing.

Deux définitions de l'informatique se sont toujours télescopées : celle concernant l'ensemble des techniques mises en œuvre pour l'utilisation des ordinateurs et celle concernant la science du traitement rationnel de l'information, notamment par des moyens automatiques. Dans le langage courant, l'information est soit l'action ou la démarche par laquelle on cherche des connaissances sur un sujet précis, soit le résultat de cette action.

On a, bien souvent, tendance à assimiler les termes information et donnée, ce dernier étant issu du vocabulaire statistique. Une donnée est l'aboutissement de tout un processus d'élaboration et de codification. Au sens informatique du terme, l'information est le résultat d'une représentation, auquel on peut appliquer des traitements qui fournissent une autre information. On s'accorde cependant pour limiter le champ de l'informatique au traitement automatique des données.

2. Historique et évolution de l'informatique

2.1. Les précurseurs de l'informatique

De tout temps, les hommes ont cherché à rendre les calculs plus rapides. Les premières machines à calculer mécaniques étaient les machines à roues dentées de Wilhelm Schickard (1592-1635), de Blaise Pascal (1623-1662) et de Gottfried Wihelm Leibniz (1646-1716). Fragiles et peu maniables, elles ne furent guère utilisées. Le premier véritable précurseur de l'informatique est l'anglais Charles Babbage (1792-1871). Sa « machine analytique », qui utilise, au xixe s., des cartes perforées indiquant les données et les opérations à effectuer, était théoriquement novatrice mais techniquement tellement complexe qu'elle n'a jamais fonctionné.

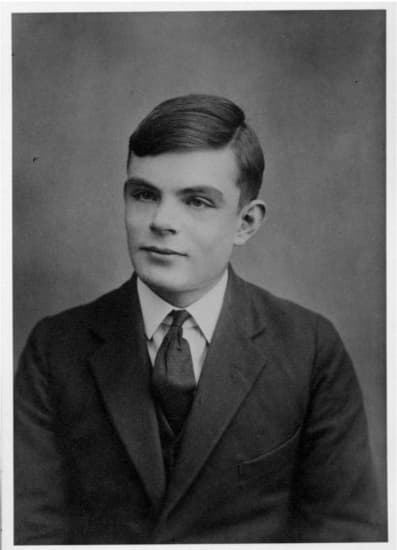

2.2. La machine de Turing

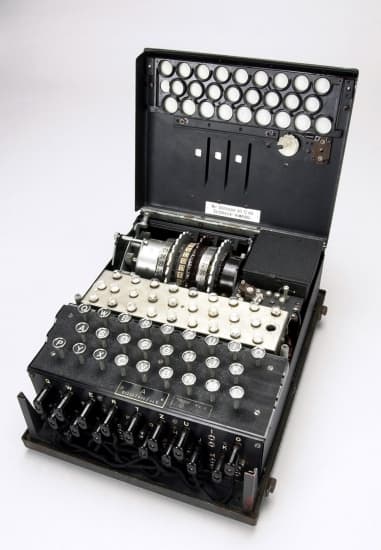

Alan Turing (1912-1954) est un mathématicien britannique qui a étudié des problèmes de logique et de fondements des mathématiques qui le conduisent à définir, en 1936, ce que l'on appelle maintenant « machine de Turing » et qui est un des concepts de base de l'informatique. C'est un pur objet mathématique abstrait, qui permet de formaliser rigoureusement la notion de calcul et de délimiter la frontière entre problèmes « calculables » et problèmes non « calculables ». La notion introduite par Turing de « machine universelle » préfigure le principe de l'ordinateur. Par ailleurs, pendant la Seconde Guerre mondiale, Turing a travaillé pour les services secrets alliés en participant à l'équipe de scientifiques qui ont utilisé des moyens automatiques de calcul pour déchiffrer les codes secrets de l'armée allemande (→ cryptographie).

2.3. La machine de von Neumann

Johann von Neumann (1903-1957), mathématicien américain d'origine hongroise, est l'un des plus brillants scientifiques du xxe s. Pendant la Seconde Guerre mondiale, von Neumann participe, entre autres, aux calculs nécessaires à la mise au point de la bombe atomique américaine (→ projet Manhattan). Pour faire ces calculs, il cherche à utiliser les calculateurs disponibles aux États-Unis. En 1944, il rencontre à l'université de Pennsylvanie J. P. Eckert et J. W. Mauchly qui construisent un très gros calculateur : l'ENIAC (Electronic Numerical Integrator, Analyser and Computer). Bien que très puissante, cette machine n'est pas encore un ordinateur. Son usage est très fastidieux et von Neumann cherche à améliorer sa conception. Avec Eckert, Mauchly et une équipe d'ingénieurs, il conçoit les plans d'une nouvelle machine qu'il appelle l'EDVAC (Electronic Discrete Variable Automatic Computer). Cette machine est fondamentalement nouvelle dans son architecture. L'innovation fondamentale est que dans sa mémoire centrale sont placés non seulement les données mais aussi le programme. Une unité de commande interne permet d'organiser le travail de la machine et les échanges avec l'extérieur.

C'est le principe de base de l'architecture des ordinateurs classiques (séquentiels). Seules les machines parallèles d'avant-garde actuelles sortent des limites de ce modèle.

2.4. Les premiers ordinateurs

Une controverse éclate rapidement entre Eckert, Mauchly et Von Neumann. Les premiers veulent construire et commercialiser immédiatement une machine de ce type et revendiquent la propriété de l'invention ; ils veulent déposer un brevet, ce que Von Neumann conteste. La justice américaine tranche et dit que l'idée de la machine n'appartient à personne, tout le monde est autorisé à construire une machine ayant cette architecture. Eckert et Mauchly fondent alors une entreprise et se lancent dans la fabrication des ordinateurs.

2.5. De l'EDVAC à l'Univac

C'est en Grande-Bretagne, en 1948, à l'université de Manchester, que sera finalement construit le premier ordinateur conçu selon le principe de l'EDVAC. Alan Turing a participé à sa mise au point technique et c'est lui qui a écrit le premier « langage » pour communiquer les informations à la machine. Ce langage très simple est composé d'une cinquantaine d'instructions et c'est la machine qui les traduit en langage binaire.

Les premiers ordinateurs étaient uniquement des ordinateurs universitaires ou militaires. C'est Eckert et Mauchly qui commercialisèrent, en 1951, l'Univac, le premier ordinateur civil jamais vendu. L'Univac utilise le langage mis au point par Alan Turing.

2.6. Un nouveau langage, le Fortran

Les progrès techniques vont se succéder rapidement. Les lampes à vide seront remplacées par le transistor, ce qui permettra la miniaturisation des machines et leur plus grande fiabilité. Mais en même temps, la science du logiciel, c'est-à-dire des programmes, fait des progrès. John Backus met au point le langage Fortran (FORmula TRANslator) en 1953. C'est le premier langage qui permet d'écrire un programme indépendant de la machine sur laquelle il est exécuté. Le langage Fortran, adapté au calcul scientifique, est toujours utilisé actuellement.

2.7. L'IBM-360

L'année 1964 est une étape importante dans l'histoire de l'industrie informatique : la firme américaine IBM commercialise l'ordinateur IBM-360. Cet ordinateur était équipé de circuits imprimés et fut un véritable succès commercial. L'informatique n'était plus seulement un outil principalement utilisé pour les applications militaires ou de recherche scientifique, elle pénétrait massivement dans les entreprises.

À cette époque, tous les ordinateurs sont encore très coûteux. Ils sont installés dans des salles climatisées dans lesquelles seuls certains informaticiens peuvent accéder. Des armées d'employées appelées « perforatrices », perforent à longueur de journée les cartes qui serviront à entrer les données.

2.8. Les premiers micro-ordinateurs

La micro-informatique se développe à partir de 1975. Les immenses progrès dans la miniaturisation des circuits conduisent à l'invention du microprocesseur, qui est l'organe de base du micro-ordinateur. Ce ne sont pas les grosses firmes comme IBM, qui à l'époque dominait le marché, qui sont à l'origine de cette invention. Les premiers micro-ordinateurs ont été mis au point et commercialisés par des étudiants contestataires californiens. La légende dit que la société Apple a été fondée dans un garage.

Lancé en avril 1977, l’Apple II préfigure le futur de l’informatique. Il peut accueillir un lecteur de disquette qui facilite la sauvegarde de données. Mais surtout, avec la sortie d’un premier tableur (Visicalc), il rencontre un franc succès dans le monde de l’entreprise. Le chiffre d’affaire d’Apple s’envole et la société devance IBM sur le marché des ordinateurs personnels.

→ logiciel.

En 1984, Apple dévoile le Macintosh qui sidère par sa simplicité inégalée : pour la première fois, une souris (inspirée des laboratoires Xerox) permet de naviguer dans une interface graphique au design épuré qui jette les bases de l’informatique grand public (le « bureau », les « icônes » et les « dossiers »). De taille réduite, doté d’un écran de 23 centimètres et d’un lecteur de disquette intégré, le Macintosh dispose d’un traitement de texte et d’un logiciel de dessin, intuitifs grâce au système d’exploitation OS. Le succès est mondial et inspirera Bill Gates pour son système Windows (Microsoft).

2.9. Évolutions actuelles

La société Microsoft de Bill Gates connaît un succès fulgurant à partir de 1981, lorsque le système MS-DOS (auquel est adjoint, à partir de 1985, le système d'exploitation Windows) est choisi par IBM pour équiper ses PC et devient un standard de la micro-informatique durant les décennies 1990 et 2000.

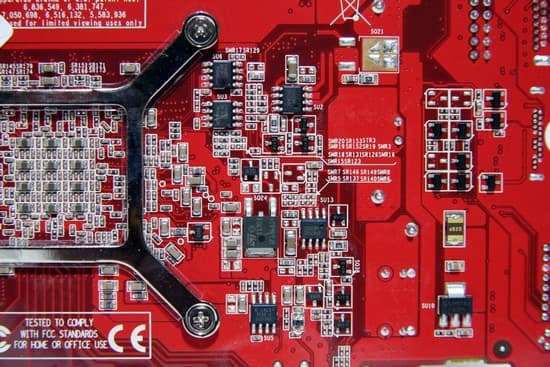

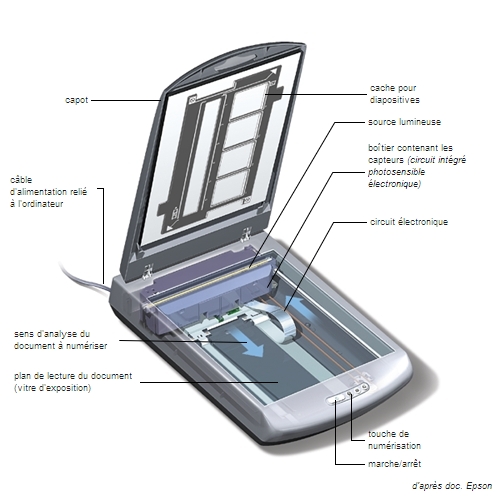

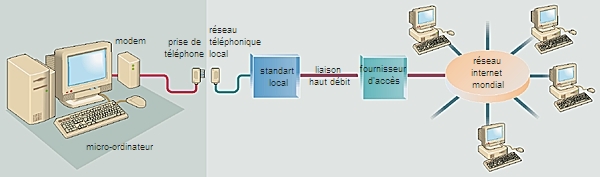

D’année en année, les performances des ordinateurs domestiques sont multipliées (notamment avec le développement des cartes son, vidéos, mémoire, etc.) tandis que les prix baissent. De nombreux foyers s’équipent d’autant que les périphériques et les logiciels associés confèrent à l’outil informatique une dimension de plus en plus ludique : imprimantes, scanners, lecteur/graveurs de CD et DVD, connexion Internet par ajout d’un modem, lectures et traitements d’images, de textes et de sons plus intuitifs, microphones, haut-parleurs, manettes de jeux et jeux vidéos variés, webcams, etc. Le principe des connexions wi-fi et Bluetooth permet de se connecter facilement à Internet et d’associer plusieurs équipements sans fil. En 1996, encore une fois, les modèles d’Apple anticipent l’avenir : pour l’iMac, le lecteur de disquette disparaît au profit d’un modem intégré. S’ensuivent la version portable (iBook) et plusieurs modèles à écran plat dont le design et les performances fédèrent une communauté d’utilisateurs, fidèles à la marque.

Début 2007, une nouvelle révolution s’amorce, cette fois dans le domaine des télécommunications : l’iPhone (Apple), puis de nombreux autres Smartphones, constituent une nouvelle génération de téléphones mobiles, dits intelligents, sans clavier mais équipés d’un écran tactile. Intégrant un navigateur Web, un GPS, un gyroscope, une caméra (→ photographie numérique) et de multiples applications téléchargeables, ils ouvrent l’ère de l’Internet mobile et de l’informatique nomade.

En 2010, la première tablette tactile, l’iPad (Apple), rencontre le succès, notamment grâce aux applications qui l’enrichissent, et ce malgré le côté hybride de l’objet (ni ordinateur, ni téléphone). Des lecteurs MP3 et vidéos sont intégrés dans tous ces outils. Pour améliorer le confort de lecture (de romans, par exemple), l’informatique a développé des liseuses qui utilisent de l’encre électronique, moins éblouissantes que les écrans rétro-éclairés (format e-book).

En 2013, la firme Google propose une nouvelle voie innovante : la « Google glass », une paire de lunette à réalité augmentée (avec superposition d'infographies, de données, sur le champ vision de l'utilisateur) équipée d'une caméra intégrée, d'un micro, d'un pavé tactile sur l'une des branches, de mini-écrans et d'un accès à Internet.

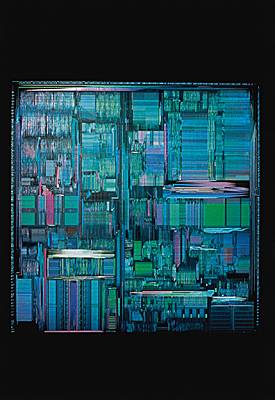

De simple curiosité technique, le micro-ordinateur s'est hissé au rang de système personnel, se taillant une place chaque jour plus importante parmi les outils de traitement de l'information en milieu professionnel, dans les domaines du commerce (vente en ligne), des loisirs, mais aussi de la vie privée (explosion des réseaux sociaux, du type Facebook avec l'avènement du Web 2.0 au début des années 2010). Aujourd'hui, la puissance de calcul d'un micro-ordinateur dépasse largement ce qu'étaient les possibilités des ordinateurs vers 1975, pour un coût d'équipement, de mise en service et de formation qui est considérablement inférieur. À la même époque, les circuits électroniques, répartis sur des dizaines de circuits imprimés de 20 × 15 cm chacun, occupaient plusieurs armoires de taille imposante. Cette même électronique occupe aujourd'hui moins de 1 cm2 sur une plaque de silicium. Les premiers microprocesseurs commercialisés en 1971 comprenaient à peine 2 000 transistors, ceux de 2012 en contiennent plus de 1 milliard.

Les ordinateurs suivent la fameuse loi de Moore qui stipule que le nombre de transistors par circuit de même taille double, à prix constants, tous les 18 mois. La limite physique à cette augmentation exponentielle de la puissance des ordinateurs (dimension des puces réduite à la taille d’un atome) devrait toutefois être atteinte vers 2020. Une nouvelle révolution informatique est donc à prévoir…

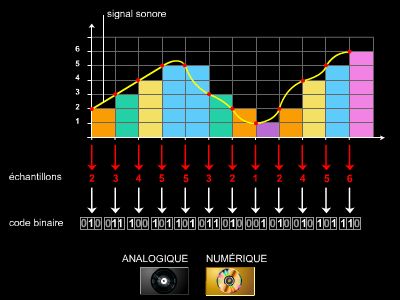

3. Le codage de l'information

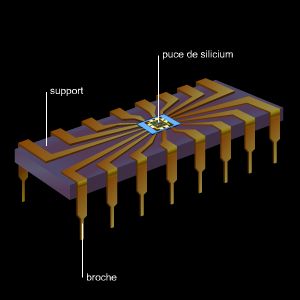

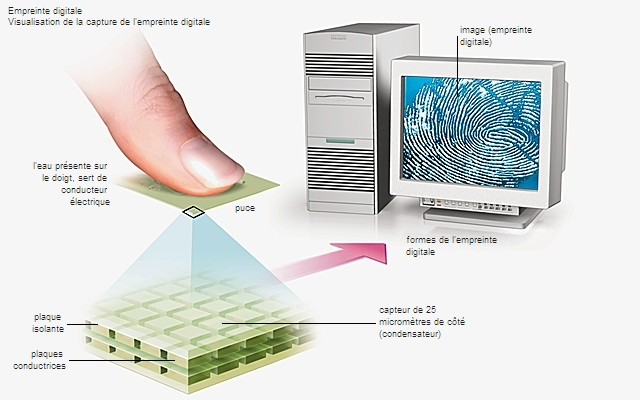

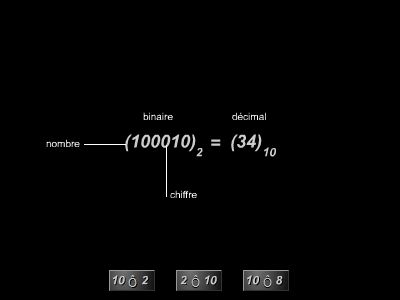

Pour traiter les données, le système informatique doit être capable de « comprendre » cette information. Les systèmes informatiques actuels comportent des circuits intégrés qui rassemblent sur une puce de silicium quelques millions de transistors. Ils ne peuvent donc fonctionner que selon une logique dite binaire déterminée par deux états logiques correspondant à deux niveaux électroniques, conventionnellement notés 0 et 1.

Le passage d'une information, d'un langage compréhensible par l'homme à un langage compréhensible par le système informatique se nomme codage.

Les informations que doivent traiter les systèmes informatiques sont composées de lettres, de chiffres et de symboles particuliers (points d'exclamation, guillemets…). On est donc amené à coder l'information pour qu'elle soit assimilée par le système. Avec un code à 1 bit (binary digit), on peut représenter deux états notés 0 et 1, soit 21 combinaisons. Pour représenter les 10 chiffres (0 à 9) utilisés dans le système décimal, il faut donc utiliser un code à 4 bits – le code à 3 bits n'étant pas suffisant puisqu'il ne permet que 23 combinaisons. Mais si nous voulons aussi représenter les lettres de l'alphabet, il faut alors un code capable de représenter les 26 combinaisons qui correspondent aux lettres en plus des 10 combinaisons qui correspondent aux chiffres, soit 36 combinaisons différentes. Il nous faut donc un code à 6 bits (215 = 32 combinaisons est insuffisant, 216 = 64 combinaisons est suffisant) qui permette de coder plus de 36 combinaisons et même des informations particulières.

3.1. Les codes utilisés en informatique

Dans le BCD (binary code decimal, « décimal codé binaire »), chaque chiffre du nombre à coder est donné par son équivalent binaire représenté sur 4 bits. Ce code est utilisé pour le codage de nombres, notamment avec le langage COBOL (COmmon Business Oriented Language).

Le code ASCII (American Standard Code for Information Interchange) est l'un des codes les plus utilisés en informatique. Défini en 1963 aux États-Unis, il a été repris par les organismes de normalisation des transmissions internationales de données, qui en ont fait le code ISO (International Standard Organization) à 7 bits. Il est souvent assimilé à un code à 8 bits, car on ajoute 1 bit de contrôle, le bit de parité .

3.2. Le « mot informatique »

Les systèmes informatiques manipulant des informations binaires travaillent en général sur une longueur fixe de bits, le mot. Suivant le système, la taille de ce mot est différente ; les tailles classiques de mots sont de 8, 16, 32 ou 64 bits. Par exemple, sur un système équipé d'un microprocesseur 8086, on utilisait des mots de 16 bits, tandis qu'avec le 360 d'IBM, ou sur une machine comportant un microprocesseur 80486, on employait des mots de 32 bits. Les microprocesseurs actuels manipulent des mots de 64 bits.

3.3. Représentation des nombres

Un nombre entier est représenté par une suite de bits.

La représentation des nombres réels (« nombres à virgule ») est assurée grâce à deux suites de bits : la mantisse, qui représente les chiffres significatifs du nombre, et l'exposant, ou caractéristique, qui indique la puissance à laquelle la base de numération doit être élevée. Ainsi, dans le nombre décimal 12 E 8, 12 est la mantisse et 8 est l'exposant. L'ensemble est équivalent à 12 . 108. On trouve, selon les constructeurs, différentes normes de représentation des nombres en virgule flottante. Il appartient au programmeur de choisir une forme de stockage des nombres adaptée à son problème.

4. Les principes du traitement de l'information

4.1. La notion d'algorithme et de calculabilité

Le traitement que la machine effectue sur les données est spécifié par ce que l'on appelle un algorithme. Il décrit la suite d'opérations élémentaires qui doivent être effectuées. (Un algorithme est quelquefois comparé à une recette de cuisine ou à une partition musicale).

L'informatique théorique, et en particulier les travaux de Turing, a permis de formaliser rigoureusement la notion de problème résoluble par algorithme (on parle de problème décidable et de fonction calculable). Un programme est l'expression d'un algorithme dans un langage de programmation.

L'exécution d'un algorithme est un processus de calcul qui peut quelquefois ne pas se terminer (on dit qu'il boucle). Ce danger est à la base de l'une des difficultés de la programmation. On montre, en informatique théorique, que le problème de la détection du bouclage est un problème indécidable, c'est-à-dire qu'il ne peut pas être résolu par un algorithme.

→ programme.

4.2. La complexité de calcul

Même si un problème est soluble par algorithme, il se peut que le temps de calcul soit prohibitif. Par exemple, si l'on est sûr que le calcul va se terminer mais qu'il faut attendre un centaine de siècles, il vaut mieux y renoncer. La machine de Turing est aussi utilisée pour la théorie de la complexité qui vise à caractériser les problèmes qui sont effectivement solubles en un temps de calcul raisonnable.

4.3. Les langages de programmation

Un programme est destiné à être exécuté par une machine mais cela n'est possible que si les instructions du programme sont directement interprétables par la machine. Écrire un programme dans le langage d'une machine est extrêmement fastidieux, que ce soit pour la machine de Turing ou pour le processeur d'un ordinateur. Il est préférable, en particulier pour éviter de faire des erreurs, d'écrire un programme dans un langage de plus haut niveau, c'est-à-dire dont les instructions sont plus proches de l'esprit humain et seraient exécutables seulement par un machine virtuelle.

Il reste ensuite à traduire ce programme de haut niveau en un langage de bas niveau interprétable par la machine qui va l'exécuter effectivement. Cette tâche de traduction est confiée à l'ordinateur, c'est-à-dire que c'est un programme, en général appelé compilateur, qui résout ce problème de traduction. La production de ces compilateurs nécessite de décrire rigoureusement la syntaxe de ces langages par des « grammaires » et de représenter la signification des programmes par des procédés formels appropriés.

4.4. La programmation

Partant d'un problème, le chemin à parcourir, pour arriver finalement à un programme qui résout convenablement le problème, n'est pas facile surtout s'il s'agit de problèmes de taille industrielle et de programmes produits par une équipe nombreuse. Les risques d'erreurs sont nombreux, à la fois dans la compréhension du problème et dans la conception du programme. D'ou la nécessité d'une science et d'une ingénierie du logiciel (génie logiciel). En particulier, il est nécessaire de mettre en œuvre des méthodes rigoureuses de conception des programmes, ce qui nécessite une connaissance approfondie, aussi bien de la structure des algorithmes que des structures de données.

Parmi les méthodes de conception de programmes en vogue actuellement citons l'approche par objets (programmation orientée objets, par exemple le Java ou le C++). Cette approche permet de maîtriser la complexité de la tâche par une abstraction des procédures et des données. Elle facilite aussi la modularité et la réutilisation des « composants logiciels » qui constituent un programme.

Le langage html (hypertext markup langage) est un langage de description de documents servant à présenter les pages web et à préciser à l’aide de balises les liens hypertextes avec d’autres documents. Il est souvent utilisé avec le Javascript et les feuilles de style de cascade (CSS).

5. L'architecture des machines et leurs systèmes d'exploitation

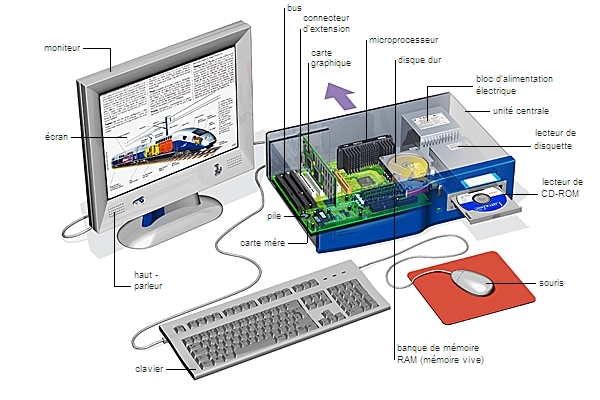

5.1. L'architecture classique

Le principe de base, très simplifié, de l'ordinateur classique (séquentiel) est l'interaction entre une unité centrale et des périphériques. L'unité centrale est constituée essentiellement d'une mémoire centrale et d'un processeur. La mémoire centrale contient le programme ainsi que les données et les résultats intermédiaires des calculs. Le processeur exécute l'une après l'autre les instructions du programme en allant les chercher en mémoire. Les périphériques sont d'une part des unités de stockage (disque dur, par exemple) et des unités d'entrée-sortie qui permettent la communication homme-machine (clavier, écran, souris, imprimante, etc).

5.2. Les systèmes d'exploitation

Pour qu'un programme d'application puisse utiliser facilement les ressources de la machine (gestion des fichiers stockés sur les disques, gestion des entrées-sorties), il existe un ensemble de programmes intermédiaires qu'on appelle système d'exploitation et qui dispense le programmeur de se préoccuper de ces questions.

Les disques et mémoires

Les disques ont un support magnétique semblable à celui des bandes, et le principe d'enregistrement des informations y est analogue. La différence fondamentale réside dans l'organisation du support en cellules adressables permettant un accès direct à l'information. Une mémoire à disques est formée d'une pile de disques animés d'un mouvement de rotation permanent et rapide, faisant défiler les pistes sous les têtes de lecture-écriture.

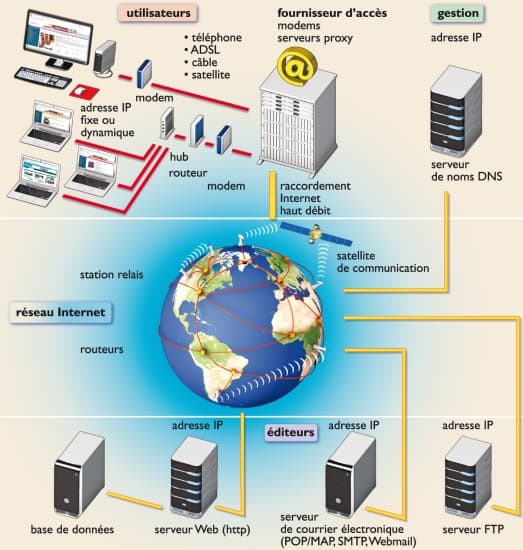

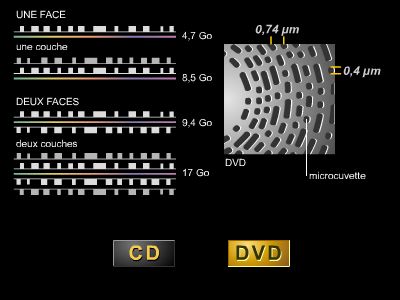

Actuellement, les disques durs équipant les ordinateurs personnels permettent de stocker jusqu’à 1 To (1 téraoctet, soient 1012 octets). Les supports de stockage de données amovibles ont considérablement évolués ces dernières décennies : les disquettes utilisées dans les années 1990 permettaient de stocker quelques centaines de Ko (kilo-octets). Elles ont été remplacées par des CD-Rom et des DVD enregistrables pouvant contenir de 600 Mo (mégaoctets) à quelques dizaines de Go (gigaoctets). Les mémoires flash et les clés USB sont aujourd’hui préférées pour les transferts rapides de données de quelques Mo, les sites F.T.P. pour les données plus volumineuses (quelques Go). Les disques durs externes, également amovibles, contiennent plusieurs centaines de Go.

Au début des années 2010, le cloud computing (informatique en nuage) qui externalise le stockage des données sur des serveurs distants, propose un nouveau mode d’accès aux informations personnelles, via Internet, à tout moment et sur tous supports connectés.

5.3. Le parallélisme

Le parallélisme est né de l'idée d'augmenter la puissance des machines pour résoudre efficacement, c'est-à-dire rapidement, des problèmes de très grande taille, en dépassant les limitations du modèle d'ordinateur de von Neumann. Une machine parallèle est un ensemble de processeurs qui communiquent et qui coopèrent. Des éléments de parallélisme sont apparus très tôt dans les ordinateurs, même dans les machines classiques, mais le besoin se fait sentir maintenant d'un parallélisme « massif », en particulier pour les applications demandant du calcul numérique intensif (notamment, les supercalculateurs utilisés pour la recherche scientifique, voir plus bas). Mais le parallélisme pose des problèmes matériels et logiciels qui sont loin d'être tous résolus.

6. Les applications de l'informatique

Tous les aspects du monde moderne sont pénétrés par les applications de l'informatique, d'autant plus qu'on assiste à une intégration entre les télécommunications et l'informatique, chacun s'appuyant sur l'autre.

La gestion des entreprises, y compris l'aide à la décision, a été l'un des champs d'applications principaux de l'informatique. Quasiment tous les secteurs ont été transformés par l'essor de l'informatique : les transports, la bureautique, la gestion de documents, l'informatique médicale, bancaire, le cinéma (→ image de synthèse) la presse et l'édition (avec la PAO, publication assistée par ordinateur), etc. Ces industries ont dû s'adapter aux techniques multimédia et aux modèles économiques de l'Internet qui reposent souvent sur un accès gratuit. L'industrie du disque souffre particulièrement du téléchargement illégal de fichiers.

6.1. L'informatisation des entreprises

Elle permet un gain de temps considérable pour les tâches répétitives. Les données traitées sont des informations précieuses utilisables à d'autres fins. En effet, les fonctions administratives évoluent : les gestionnaires peuvent s'interroger sur les tendances de la masse salariale, l'élaboration du bilan annuel, mais aussi sur l'échéancier des commandes, l'incidence d'un plan de formation sur les salaires. Les informations contenues dans les bulletins de salaire ou les états comptables peuvent être exploitées et permettre une simulation de commande ou de trésorerie, le calcul de l'incidence d'une prime sur certaines catégories de personnel, l'établissement d'un historique des qualifications ou d'un suivi de carrière…

L'informatisation touche de plus en plus les métiers de l'entreprise, par conséquent les professionnels collaborent plus étroitement avec les informaticiens. La diffusion de la technologie des réseaux locaux permet le développement d'une informatique dite répartie et en particulier du modèle client-serveur.

6.2. Le modèle client-serveur

Dans les années 1970, l'architecture des systèmes d'entreprise était caractérisée par une centralisation autour de gros ordinateurs auxquels on accédait par des terminaux. Les utilisateurs de ces systèmes étaient très dépendants des constructeurs. Les années 1980 ont vu le développement des base de données dans l'entreprise. Deux phénomènes se sont produits : d'une part une ouverture permise par exemple par la diffusion du système d'exploitation UNIX, qui ne dépend pas d'un constructeur particulier ; d'autre part le développement des réseaux locaux. Cette évolution a posé le problème du partage des données par plusieurs utilisateurs du réseau. Elle a permis l'émergence d'un modèle d'architecture dit « client-serveur ». Il est caractérisé par la distinction entre deux catégories de machines dans le réseau : les ordinateurs « serveurs », qui gèrent des données partagées entre plusieurs utilisateurs ; les stations de travail des utilisateurs (ou « clients »). Le client envoie des requêtes, c'est-à-dire interroge les bases de données du serveur.

6.3. L'automatisation de la production

La gestion de la production assistée par ordinateur (GPAO) d'une entreprise fait appel à des systèmes complexes et remet en question l'organisation de la production. Grâce à un suivi constant et automatique de la production, il devient possible de prévoir le marché et de s'y adapter. L'outil micro-ordinateur oblige à un choix stratégique des informations à traiter, et transforme les fonctions techniques de la production en fonctions décisionnelles. Le suivi de la production va par exemple permettre, à partir de contraintes extérieures et de coûts internes, d'optimiser les décisions sur les occasions favorables ou sur la rationalisation des dépenses internes (→ gestion). La simulation, une fonction puissante de ce pôle, permet, pour une production donnée, de faire varier des paramètres (délais de livraison, prix des matières premières, temps de production d'un poste de travail) afin de déterminer une stratégie de production.

6.4. L'intelligence artificielle

C'est encore un article de Turing, daté de 1947, qui est considéré comme l'un des points de départ de l'intelligence artificielle. Il s'agit de faire en sorte que des machines réalisent des comportements considérés comme intelligents, en particulier simulent l'intelligence humaine.

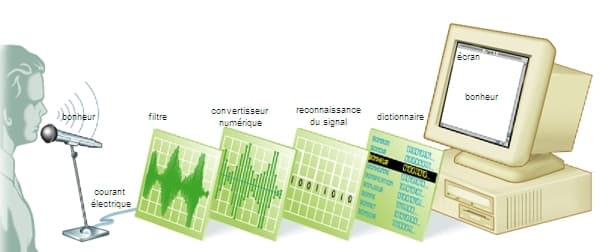

Les premières recherches en intelligence artificielle concernent la résolution de problèmes puis les robots intelligents. Le domaine de l'intelligence artificielle comprend aussi le traitement de la langue naturelle, en particulier l'aide à la traduction automatique de langues étrangères, la perception et la reconnaissance des formes.

Les « systèmes experts » permettent de représenter et de gérer des connaissances dans divers domaines comme en médecine par exemple.

Les « réseaux neuronaux » sont une autre approche de l'intelligence artificielle basée sur un modèle inspiré par les neurones du cerveau.

Dans les années 1950, les échecs ont constitués un objectif de modélisation en intelligence artificielle et dès 1997 l'ordinateur Deeper Blue l'emportait sur le champion de la discipline, Garri Kasparov. En 2016, le programme Alphago de Google Deepmind bat l'un des meilleurs joueurs mondiaux du jeu de go, Lee Sedol (ce jeu d'origine chinoise comprend bien plus de combinaisons que les échecs). L'intelligence artificielle séduit beaucoup les industriels et les géants du numérique comme Google ou Facebook ; cependant, elle en inquiète d'autres comme le scientifique Stephen Hawking ou Bill Gates. En 2017, beaucoup de produits high-tech sont estampillés « intelligence artificielle » souvent pour des raisons marketing. Une machine peut s'adapter, faire évoluer ses objectifs, mais aucune n'a pu passer le célèbre test de Turing, propre à l'intelligence artificielle, ou faire preuve de conscience.

6.5. Le calcul scientifique

Il s'agit de traiter des problèmes de modélisation, simulation, optimisation (souvent à l’aide de supercalculateurs). Par exemple : calcul d'une aile d'avion, prévisions météo, modèles économiques.Réservés aux traitements de données extrêmement lourds et complexes, les supercalculateurs, ou superordinateurs, sont avant tout utilisés pour la recherche. Certains dépassent, en 2012, la dizaine de pétaflops, soient plusieurs millions de milliards d’opérations par seconde.

7. La Commission nationale de l'informatique et des libertés (CNIL)

En France, selon la loi du 6 janvier 1978, l'informatique ne doit, en aucun cas, porter atteinte ni à l'identité humaine, ni aux droits de l'homme, ni à la vie privée, ni aux libertés individuelles ou publiques. Aucune décision de justice, aucune décision administrative ou privée impliquant une appréciation sur un comportement humain ne peut donner lieu à un traitement automatisé. C'est la Commission nationale de l'informatique et des libertés (CNIL) qui est chargée de veiller à ce que les traitements automatisés publics ou privés d'informations nominatives soient effectués conformément à la loi.

Toute personne justifiant de son identité a le droit d'interroger l'organisme traitant et d'obtenir les informations le concernant. Toutefois, lorsqu'il s'agit d'informations médicales, celles-ci ne peuvent être transmises à l'intéressé que par l'intermédiaire d'un médecin qu'il désigne à cet effet.

L'INFORMATIQUE QUANTIQUE

La puissance de calcul des ordinateurs n'a cessé de croître, doublant régulièrement tous les deux ans. Il existe cependant des problèmes dont la solution est trop complexe pour qu'un ordinateur classique les traite efficacement. Des ordinateurs utilisant les propriétés étranges du monde quantique pourraient s'y attaquer en offrant une puissance de calcul inimaginable.

Les ordinateurs classiques traitent de façon efficace certains problèmes. La multiplication de deux nombres se calcule en un temps qui ne croît, dans le pire des cas, que comme le carré du nombre de chiffres impliqués. Un algorithme, un programme dont le temps d'exécution croît comme une puissance de la taille des données est considéré comme efficace, le problème qu'il résout comme facile. En revanche, la solution d'un problème difficile requiert un temps qui croît exponentiellement avec la taille des données (comme la valeur du nombre, non comme le nombre de chiffres ou de bits). La décomposition d'un nombre entier en facteurs premiers (la factorisation) est sans doute un problème difficile.

L'algorithme naïf consiste à essayer systématiquement tous les diviseurs. Le temps de calcul croît comme la racine carrée du nombre considéré. Pour l'instant, on ne connaît pas d'algorithme qualitativement beaucoup plus rapide. À titre d'exemple, calculer le produit de deux nombres premiers de 64 et 65 chiffres ne prend que quelques microsecondes. À partir du nombre de 129 chiffres obtenu (environ 400 bits), retrouver les facteurs a pris des mois avec un réseau de gros ordinateurs. Même si la puissance de calcul a doublé depuis, la factorisation d'un nombre de 150 chiffres prendrait encore des mois. La solution d'un problème d'échecs, la recherche d'un élément dans une liste non triée sont aussi des problèmes complexes.

En raison de sa difficulté et de la simplicité du problème inverse, la factorisation est utilisée dans les systèmes cryptographiques. La multiplication du message, codé comme un nombre, par une clé secrète suffit à le rendre inaccessible. Le destinataire peut en prendre connaissance par une simple division. La plupart des systèmes cryptographiques modernes reposent sur ce principe. Un algorithme de factorisation efficace aurait des conséquences économiques incalculables.

La logique quantique

Si les ordinateurs traditionnels sont peu efficaces pour factoriser, c'est parce qu'ils ne traitent qu'une information à la fois. On peut faire fonctionner en parallèle plusieurs processeurs, mais la méthode est limitée : pour rendre « facile » la factorisation, il faudrait autant de calculateurs que de diviseurs à essayer! On remplace un temps de calcul exponentiel par un coût exponentiel, tout aussi insupportable. Exploiter, dans un ordinateur, les propriétés de la mécanique quantique permettrait peut-être de contourner cette difficulté.

Pour en savoir plus, voir l'article informatique quantique.