force

(bas latin fortia, du latin classique fortis, courageux)

Concept traduisant quantitativement les interactions entre objets et permettant d'expliquer leurs déformations ou les modifications de leurs mouvements.

PHYSIQUE

Introduction

Les différentes forces – gravitationnelle, électrique, électromagnétique ou nucléaire – qui régissent les mouvements et l'évolution des objets terrestres ou célestes sont devenues familières sans pour autant être appréhendées dans leur signification véritable. En effet, notion d'ordre physiologique, la force rappelle plutôt les plans inclinés ou les poulies des problèmes scolaires que les particules élémentaires, l'effort musculaire de l'homme ou de l'animal plutôt que la force d'attraction des planètes qui freine l'expansion de l'Univers.

Peu de mots scientifiques sont plus familiers que celui de force. Quoi de plus usuel que d'évoquer la force d'un homme, d'un animal, du vent ou d'autres phénomènes naturels ? Il est par contre beaucoup moins naturel de dire qu'une pierre tombe en raison de la force qu'elle subit de la part de la Terre, et encore plus étrange de penser que la cohésion de la matière des objets qui nous entourent est due à d'autres types de forces.

Lorsqu'on attribue naturellement de la force à des phénomènes naturels ou à des machines, la comparaison avec l'homme ou avec l'animal est implicite. La notion de force est donc anthropomorphique, et l'on pourrait retracer l'histoire de la physique parallèlement à l'évolution de ce mot vers un concept autonome débarrassé de cet anthropomorphisme.

Le mot « force » n'est pas le seul à avoir été puisé dans le vocabulaire courant pour devenir un concept scientifique. Ses voisins immédiats comme « travail », « puissance » ou « énergie » ont subi le même sort, qui consiste à devenir concepts à l'intérieur d'un système d'équations mathématiques tout en demeurant proches d'un contenu sémantique intuitif. On parlera facilement du travail fourni par le déplacement d'un poids, d'une force, ou de la puissance d'un moteur. Il est de même courant aujourd'hui d'évoquer la force d'attraction entre le Soleil et les planètes, entre deux charges électriques ou entre les composants du noyau de l'atome sans quitter vraiment le domaine de nos représentations usuelles. Mais celles-ci sont cependant considérablement éloignées de la notion originelle de la force de l'homme ou de l'animal, qui agit par contact, tandis que celles que nous venons d'évoquer semblent bien agir à distance. L'action à distance constitue sans doute une étape essentielle dans l'autonomisation de la notion de force et est acceptée très aisément aujourd'hui dans notre représentation du monde. Ce sont au contraire les théories, anciennes ou contemporaines, qui, lorsqu'elles remplacent toute action à distance par des chocs ou des échanges de particules, nous éloignent de l'intuition et des représentations courantes.

Historique de la notion de force

La physique d'Aristote distingue l'étude des objets naturels de celle des objets fabriqués par la ruse de l'homme, les machines. Les phénomènes naturels comme la chute d'une pierre sont soumis à des causes tandis que les machines, comme l'homme, transmettent des forces. Or le geste qui consiste à jeter une pierre ou à lancer une flèche est considéré comme mettant en jeu une force, au même titre que la machine. Puisque toutes les forces agissent par contact, on se demande alors pourquoi la flèche et la pierre continuent à se mouvoir après que la main du lanceur les a lâchées. Ce simple problème de la physique aristotélicienne va entraîner, après bien des tentatives d'aménagement, la faillite complète du système et la reconnaissance de la persistance du mouvement uniforme dès le xive s., de la relativité par Galilée en 1632, et, enfin, de l'action à distance par Isaac Newton, en 1687.

Mais ce lent bouleversement tient compte de la redécouverte de traditions antiques, constituées par les traités archimédiens et par ceux de Héron d'Alexandrie sur les machines simples. Il s'agit essentiellement d'une physique de forces statiques mettant en jeu une logique des équilibres qui culminera au xvie s. avec l'hydrostatique de Simon Stevin. Mais elle inclut également les déplacements des bras de la balance, des roues et des poulies, ce qui conduit à une étude du lien entre force et mouvement, laquelle fait croire à une proportionnalité entre force et vitesse.

La physique newtonienne n'est pas la seule solution proposée au xviie s. en réponse aux problèmes posés par l'étude du mouvement. Peu après la publication des œuvres de Galilée, René Descartes tente d'imposer une théorie, qui sera ensuite appelée le « mécanisme », dans laquelle toute action s'effectue par des chocs de particules invisibles. C'est le mécanisme qui fournit à cette époque la vision la plus simple et la plus rationnelle du monde, tandis que l'action à distance évoque les forces occultes de l'alchimie, avec pour seul soutien un peu plus objectif l'action des aimants. L'explication par l'existence de particules invisibles prend sa source dans l'atomisme antique et persistera, en constante opposition à la trop mystérieuse action à distance.

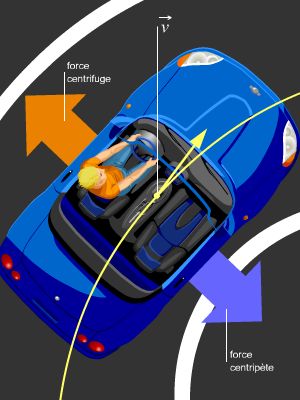

Christiaan Huygens énonce, vers 1656, les lois des chocs élastiques telles que nous les connaissons aujourd'hui, lois fondamentales dans le modèle du mécanisme cartésien, auquel il adhère. Il a dû, pour y parvenir, abandonner l'étude de la force de « percussion » entre deux corps en collision, car cette force, déjà étudiée par Galilée et Evangeslista Torricelli, échappe à toute mesure en raison de son caractère instantané. Huygens a alors déduit les lois des chocs à partir de l'invariance galiléenne de tout phénomène, et donc de toute force. Les lois de la force « centrifuge », établies ensuite, complétèrent sa mécanique.

Tandis que Descartes et Huygens étudient la gravitation par des chocs de très nombreuses particules invisibles en mouvement tourbillonnaire incessant, Newton impose, à la suite de Johannes Kepler, une action à distance comme explication causale universelle. Il fait alors pour la première fois de la notion de force un vrai concept en l'intégrant dans un système mécanique complet. La force « imprimée » au corps sera déterminée par le changement du « mouvement », c'est-à-dire la quantité de mouvement. La vitesse est connue grâce au cadre fourni par le temps et l'espace « absolus », et la force « inertielle » est la puissance que possède le corps de résister à tout changement de vitesse par rapport à cet espace absolu. La force fondamentale pour la gravitation est « centripète », et non plus centrifuge comme chez Huygens.

L'étude de l'électricité et du magnétisme, au xviiie s., par Henry Cavendish et Charles Augustin de Coulomb s'effectue naturellement dans le cadre de la mécanique newtonienne puisqu'on y « voit » des actions à distance. Ces actions entre aimants ou entre charges statiques permettent de retrouver fort à propos les principales propriétés de la force de gravitation newtonienne : proportionnalité aux masses et à l'inverse du carré de la distance entre les deux masses et dirigée le long de l'axe qui les relie.

Par ailleurs, Cavendish, l'un des savants les plus novateurs dans le domaine de l'électrostatique, a montré en 1773 que les forces électrostatiques sont soumises aux lois de la gravitation : elles sont inversement proportionnelles au carré des distances entre les charges.

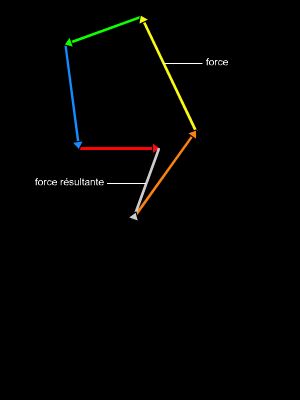

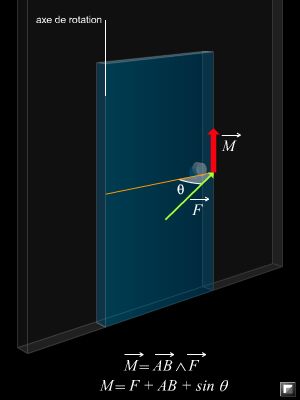

Mais les actions entre courants électriques font apparaître des forces qui ne sont plus dirigées selon la ligne qui relie les deux éléments de courants considérés. La description de ces forces électromagnétiques provoque le développement d'un formalisme vectoriel nouveau au cours de la seconde partie du xixe s., et on considère dorénavant que chaque charge et chaque courant créent en permanence autour d'eux un « champ » vectoriel en chaque point de l'espace, tel que l'on puisse à partir de ce champ évaluer directement la force qui s'exercerait sur une charge ou un courant placés en ce point. Ce champ peut lui-même, sous certaines conditions, être déduit d'un « potentiel », c'est-à-dire d'une quantité scalaire, et non plus vectorielle, en chaque point de l'espace.

Ces champs vectoriels et scalaires étaient supposés se produire instantanément dans l'espace jusqu'à ce que James Clerk Maxwell établisse en 1873 qu'ils se propagent comme une onde à la vitesse de la lumière. La force électromagnétique devient alors le résultat presque secondaire d'un formalisme totalement inédit.

La gravitation est traitée elle aussi dans cette perspective complètement nouvelle, qui permettra de découvrir que les variations du champ gravitationnel se propagent à la vitesse de la lumière.

L'histoire ne s'arrête pas là. À partir du moment où on se rend compte, à la suite des travaux d'Albert Einstein et de Max Planck, que toute énergie varie de façon discontinue, toute interaction doit être quantifiée et devient descriptible par un échange de particules. On pourrait dire que l'on est revenu à un strict mécanisme, à ceci près que le choc n'est plus traité en termes de force mais en termes d'échanges d'énergie. La force ne disparaît pas pour autant, car le formalisme permet toujours de retrouver, au terme de calculs compliqués, des quantités qui correspondent aux forces d'interaction de la physique du xviiie et du xixe s. entre les corps macroscopiques, mais aussi de découvrir de nouveaux types de forces entre des corps microscopiques.

La force et sa mesure en mécanique classique

La dynamique newtonienne établit un véritable concept universel de force par la proportionnalité entre cette force et le changement de la vitesse (accélération du mouvement), et par l'égalité de l'action et de la réaction. Les forces qui s'exercent entre les corps célestes ou entre les corps microscopiques ne peuvent cependant pas être mesurées autrement que par les mouvements qu'elles engendrent, et on ne peut parler de vérification des lois newtoniennes.

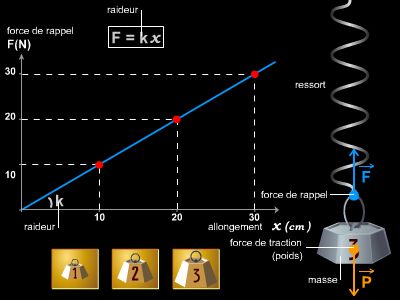

Dans le seul domaine des corps terrestres, celui des machines, ou « mécaniques », il est possible de mesurer les forces par un effet statique particulier : celui de l'allongement d'un ressort appelé alors « dynamomètre ». On peut dire que l'allongement du ressort est proportionnel à la force parce qu'il est proportionnel, par exemple, aux poids qu'on lui accroche, les rapports de ces poids étant connus grâce à une balance. Mais la mesure de la force par le ressort ne donne un bon résultat que si l'on se trouve dans un « bon » repère. Si on utilise ce dispositif dans un véhicule se déplaçant à vitesse constante, l'allongement du ressort sera le même qu'à l'arrêt, mais, si la vitesse du véhicule est augmentée, l'allongement correspondant à une même traction de la main sera différent. On dira alors qu'à la force exercée par la main s'est ajoutée une « force d'inertie », proportionnelle à l'accélération du dispositif et de sens contraire.

La mesure de la force classe donc les repères en différents ensembles, constitués par les repères équivalents animés les uns par rapport aux autres de vitesses constantes, et la mécanique newtonienne considère qu'un de ces ensembles est plus fondamental que les autres et constitue un repère « absolu ». C'est en première approximation le repère lié à la Terre, puis au Soleil, et enfin aux étoiles lointaines.

Les différents types de forces

Dans l'histoire de la physique émergent successivement différents domaines, situés chacun autour d'une loi caractéristique. On admet qu'un objet sur lequel ne s'exerce aucune force ne peut se déplacer qu'en ligne droite, à vitesse constante. Si la vitesse varie, en grandeur ou en direction, le phénomène ne peut s'expliquer que par la présence d'une force. Il s'agit alors soit d'une force d'inertie, soit d'une interaction.

Les forces d'inertie

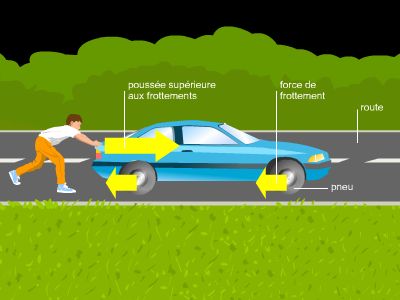

La vitesse du corps paraît varier parce qu'elle est mesurée par rapport à un référentiel lui-même en mouvement. Il y a alors trois cas possibles : la force d'inertie de translation (qui provient d'un freinage ou d'une accélération), la force centrifuge (due à un changement de direction) et la force de Coriolis, utilisée pour décrire le mouvement des vents en tenant compte de la rotation de la Terre.

Les interactions

La vitesse du corps varie sous l'influence d'un autre corps placé dans le voisinage.

La force gravitationnelle

C'est la force newtonienne

s'exerçant entre deux masses M et M′ :

s'exerçant entre deux masses M et M′ :

; la constante G étant très petite, cette force n'est importante qu'entre de grosses masses célestes, ou entre les corps terrestres et la Terre.

; la constante G étant très petite, cette force n'est importante qu'entre de grosses masses célestes, ou entre les corps terrestres et la Terre.

Le premier instrument de mesure de cette force est donc la balance, qui compare les forces exercées par la Terre sur deux corps, avant que le ressort, au xviiie s., ne mesure cette force sur un seul corps. La force d'attraction gravitationnelle s'exerçant entre deux corps terrestres est donc très faible ; elle est cependant mesurée directement entre deux corps terrestres, en 1798, par Cavendish grâce à une balance coulombienne.

La force électrique

C'est la force qui s'exerce entre les charges électriques q et q′, charges mises en évidence auparavant par Benjamin Franklin :

.

.

Coulomb la mesure grâce à sa fameuse balance de torsion en 1785. Elle a pour direction la droite qui joint les charges et s'écrira plus tard

en fonction du champ électrique vectoriel E.

en fonction du champ électrique vectoriel E.

La force électromagnétique

C'est la loi de Biot et Savart qui traduit l'action d'un élément

parcouru par un courant I sur un autre élément de courant de même nature :

parcouru par un courant I sur un autre élément de courant de même nature :

où

où

.

.

Pour obtenir la force exercée par une charge q animée d'une vitesse

sur une autre charge, il suffit de remplacer l'élément

sur une autre charge, il suffit de remplacer l'élément

par le produit

par le produit

. On obtient donc l'expression générale

. On obtient donc l'expression générale

, qui est la force de Lorentz exercée sur une charge q se déplaçant à vitesse v dans un champ électromagnétique

, qui est la force de Lorentz exercée sur une charge q se déplaçant à vitesse v dans un champ électromagnétique

, dans le vide.

, dans le vide.

La force nucléaire forte

Selon le modèle atomique de Niels Bohr de 1913, le noyau contient des neutrons et des protons tandis que les électrons tournent sur diverses orbites extérieures, maintenus par interaction électromagnétique avec les protons chargés positivement. L'interaction électromagnétique assure donc la cohésion de l'atome. Mais comment les protons se maintiennent-ils ensemble à l'intérieur du noyau malgré la répulsion électrique ? La cause de cette stabilité du noyau est décrite comme une force nucléaire très intense entre les protons et les neutrons, à « courte portée » car elle ne doit pas intervenir hors du noyau. Cette force est à l'origine de l'énergie nucléaire obtenue lorsqu'on « casse » l'atome (réaction de fission nucléaire).

La force nucléaire faible

Pour rendre compte de phénomènes expérimentaux nouveaux comme la radioactivité, il a fallu ajouter une dernière sorte de force, beaucoup plus faible que la force électromagnétique et de portée mille fois plus courte encore que celle de la force nucléaire forte. C'est la force la plus discrète de la série, la plus éloignée des phénomènes quotidiens et des représentations de notre monde.

L'unification des forces

L'énumération précédente incite à penser que ce processus de découverte de nouvelles forces pourrait continuer. À chaque nouveau phénomène inexpliqué, une nouvelle force apparaîtrait, comme si on se retrouvait, malgré la sophistication technique, dans une description plus phénoménologique que scientifique. Or l'une des principales visées de la science, sinon la seule, est sûrement de réunir les diverses catégories de faits propres à chaque théorie en une seule. Les grands succès scientifiques sont d'ailleurs presque toujours liés à une telle réunion, qui, par la simplification et la représentation qui en découlent, nous fait saisir ensemble, donc comprendre, les phénomènes. Toute unification résulte d'une démarche volontaire, souvent longue et délicate, mais qui n'est jamais fortuite. Descartes avait tenté de rassembler toutes les interactions en une seule : celle du choc. Newton accomplit l'union de la gravitation terrestre et de la gravitation céleste. Mais le magnétisme, l'électricité, la pression, les forces de résistance et de tensions superficielles dans les fluides demeurent hors du domaine de la gravitation.

La théorie cinétique des gaz de Rudolph Clausius apparaît comme un succès tardif du mécanisme unificateur de Descartes dans la mesure où chaleur et pression ont dorénavant pour unique cause les chocs entre les molécules ou atomes des gaz. La pression exercée par un gaz s'écrit alors simplement en fonction de la vitesse d'agitation moyenne v des particules : P = ½ n . M . v2, où n est le nombre de moles par unité de volume, et M la masse molaire. Cette expression est donnée par Clausius en 1857. La pression avait déjà été reliée à la température par la loi de Louis Joseph Gay-Lussac en 1802 : PV = n RT. Les grandeurs macroscopiques P et T sont désormais déduites de grandeurs microscopiques liées aux composants du gaz. Le succès de cette théorie est évident, et Ludwig Boltzmann la développe en véritable théorie statistique. Mais l'existence des atomes ne sera cependant admise par l'ensemble de la communauté scientifique qu'après les mesures du nombre d'Avogadro par Jean Perrin en 1908 et par Robert Andrew Millikan en 1909.

L'unification de l'électricité et du magnétisme est obtenue au xixe s. au terme d'une recherche qui – beaucoup plus difficile que celle de Clausius – est tout à fait passionnante. Elle débute avec la mise en évidence en 1820 de l'action d'un courant sur un aimant par Hans Christian Œrsted, expérience qui met fin à de nombreuses tentatives de détection de l'action d'une charge sur un courant. Le magnétisme sera dorénavant associé à des charges non plus statiques mais en mouvement. André Marie Ampère, François Arago, Jean-Baptiste Biot et Michael Faraday se mettent alors au travail pour formaliser les interactions entre courants. Ampère donne un modèle d'aimant qui consiste en une série de boucles de courant perpendiculaires à l'axe de l'aimant, puis Augustin Fresnel émet l'hypothèse de l'existence de telles boucles autour de chaque particule.

Lorsque Ampère cherche à détecter la production d'un courant par l'effet d'un autre courant, il reproduit l'erreur de ceux qui recherchaient l'action d'une charge sur un aimant : rechercher un effet permanent au lieu d'un effet différentiel. On pourrait dire que l'on reproduit encore spontanément l'erreur qui consiste à lier la force à la vitesse au lieu de la lier à l'accélération. Mais, de même que seul le changement du mouvement, et non le mouvement lui-même, provient d'une force, la force électromagnétique est due à un déplacement de charges et non à une charge, et la force d'induction à une variation du courant et non au courant lui-même.

Les forces magnétiques sont donc de même nature que les forces électriques, mais « transversales », c'est-à-dire de direction différente de celle qui relie les sources, et dues à des charges en mouvement et non pas statiques. On parle aujourd'hui de forces électromagnétiques.

Or le phénomène de polarisation de la lumière avait déjà contraint les physiciens à concevoir celle-ci comme une vibration transversale, différente de la vibration longitudinale acoustique. Fresnel avait alors tenté de décrire sa propagation dans un « éther » qui, au lieu d'être constitué de particules comme c'était le cas chez Descartes et Huygens, était conçu comme un solide cristallin capable de propager des vibrations transversales. Maxwell tente le premier l'unification de la lumière et de l'électromagnétisme en mettant en évidence à l'intérieur d'un système d'équations une propagation d'actions électromagnétiques transversales à la vitesse de la lumière. Heinrich Hertz confirme cette hypothèse théorique en détectant expérimentalement en 1888 ces ondes électromagnétiques de longue portée, tout à fait semblables à la lumière quoique invisibles parce que situées dans un autre domaine de fréquence. Les scientifiques ne se satisfont pas de cette fantastique réussite. Il semble encore une fois que rien ne soit expliqué tant que l'on ne possède pas un modèle mécanique pour ces étranges interactions transversales. Ampère avait envisagé des tourbillons autour des lignes de champ, Maxwell reprend le modèle d'éther cristallin de Fresnel pour la propagation de toute action électromagnétique. Mais cet éther, quoique sans masse et non résistant, devait pouvoir être détecté cinématiquement, c'est-à-dire comme un milieu ayant un état de mouvement donné. On chercha alors à mettre en évidence le mouvement des sources lumineuses et des récepteurs par rapport à cet éther. L'échec de ces tentatives aboutit à l'abandon définitif de ce modèle en 1905 par Einstein. Les interactions électromagnétiques se propagent donc dans le vide, et la gravitation aussi.

La théorie de la gravitation, établie par Einstein en 1915 sous le nom de « relativité générale », remplace les actions gravitationnelles par une courbure d'un espace-temps à quatre dimensions. Ce sont désormais des modifications de cette courbure et non plus des forces qui se propagent à la vitesse de la lumière dans le vide. Einstein souhaite traduire les forces électromagnétiques dans une perspective analogue à celle de Theodor Kaluza puis d'Oskar Klein, interprétant la gravitation grâce à une cinquième dimension ajoutée à l'espace-temps de la relativité générale.

Mais à peine se trouve-t-on à nouveau en présence d'une sorte d'action à distance que d'autres interprétations mécanistes émergent en raison d'une nouvelle contrainte : la quantification de l'énergie et de toutes les quantités physiques. L'expérience de l'effet photoélectrique, interprétée par Einstein en 1905, montre que la lumière ne peut transporter que des multiples d'une énergie fondamentale élémentaire, qui est fonction de la fréquence. Il s'ensuit que toutes ces forces qui se propagent dans le vide à la vitesse de la lumière doivent également se propager par quanta. La discontinuité de l'énergie propagée peut donc être décrite comme celle d'un échange de particules, les photons, particules lumineuses sans masse.

Aux forces nucléaires forte et faible sont associées des particules messagères de ces interactions. Les mésons π pour l'interaction forte et des bosons W+ et W− et Z° pour l'interaction faible. À chacune de ces particules correspond en particulier un nombre, appelé spin, lié à son énergie de rotation sur elle-même. Le spin, quantifié également, ne prend que des valeurs entières pour les messagers des forces nommées bosons, alors qu'il est toujours demi-entier pour des particules constitutives de la matière nommées fermions, comme l'électron ou les protons et neutrons du noyau. Les mésons π ont ainsi un spin nul tandis que le photon a un spin égal à 1.

Or on se rend compte que si on parvient à décrire la gravitation par un échange de particules, celles-ci doivent avoir un spin égal à 2, tandis que les mésons π des interactions faibles ont un spin entier, comme le photon. Il est alors naturel de tenter l'unification des forces électromagnétiques avec les interactions faibles plutôt qu'avec la gravitation. Les difficultés rencontrées pour y parvenir ont montré à quel point l'unification des forces de la nature résulte toujours d'une volonté délibérée et non pas de la simple évolution des outils théoriques.

Cette dernière unification est accomplie par Sheldon Glashow, Abdus Salam et Steven Weinberg dans les années 1970, dans le cadre d'un formalisme qui n'a plus rien à voir avec celui de la force : les symétries du système, plus exactement les invariances d'une fonction caractéristiques du système, permettent de déterminer les particules messagères grâce à un nouveau type de théories, appelées « théories de jauge ». De la fonction caractéristique, appelée « lagrangien » en souvenir de son inventeur Joseph Louis de Lagrange, on peut évidemment déduire par dérivation les équations du mouvement et aussi des forces, mais ces forces « généralisées » ne coïncident qu'occasionnellement avec nos forces habituelles.

L'unification électrofaible, fondée sur des symétries plus générales que celles de chacune des théories prises séparément, a exigé de nouvelles particules messagères. La sophistication de la théorie utilisée n'empêche cependant pas la confrontation avec l'expérience, et c'est en 1983 que l'on a détecté, au Cern, les bosons essentiels à la théorie : les W+, W− et Z° (ce dernier ayant été ajouté pour les besoins de l'unification).

On continue cependant à parler de « forces », et la force nucléaire forte se trouve décrite par des échanges de gluons entre les quarks, nouveaux composants des protons et neutrons du noyau, les nouvelles particules étant de spin entier et non plus de spin nul comme les mésons π.

On se rapproche ainsi d'une unification plus globale, cependant encore inachevée. Une seule force fondamentale se révèle encore réfractaire à toute unification de ce type : la gravitation. L'augmentation du nombre de particules nécessaire au traitement des interactions fortes avait suscité une description de ces particules en termes de modes de vibration de « cordes » de très petites dimensions, comme les différents modes de vibration d'une même corde de violon. Pour tenter une unification globale des actions électrofaibles et -fortes avec la gravitation, il faut combiner des procédés relevant de la théorie des cordes avec ceux qui sont issus de la théorie de Kaluza-Klein et travailler dans des espaces de dimension au moins égale à 10. Mais ces théories de « supercordes » demeurent encore extrêmement spéculatives et ne peuvent aujourd'hui être sujettes à l'expérimentation.

Une physique sans forces est-elle possible ?

Pourrait-on affirmer que le mot « force » ne subsiste dans la physique contemporaine que comme un résidu, une habitude, qui serait la trace d'un anthropomorphisme aujourd'hui disparu ?

La théorie utilise principalement la notion plus générale d'interaction, terme qui recouvre des échanges de particules ou d'énergie, à la place de celle de force. Cette dernière persiste cependant pour désigner plutôt l'action à distance équivalente que l'action de contact de ces particules. Une physique fondée sur des échanges de particules ne peut cependant pas être dite vraiment « sans forces », car celles-ci sont encore présentes dans le formalisme. La description des phénomènes par l'énergie plutôt que par la force remonte au xviie s. On l'appelle alors « force vive », mais on ne l'utilise pas sans en déduire des forces au sens habituel du terme. La description lagrangienne remonte également au xviie s. sous la forme d'un « principe de moindre action », mis au point par Pierre de Fermat, puis par Maupertuis et d'Alembert, avant sa systématisation par Lagrange en 1788. Elle constitue une physique véritablement différente de celle de la force. La trajectoire de la particule entre deux points donnés y est en effet déterminée par optimisation d'une quantité obtenue en intégrant le lagrangien sur un ensemble de trajectoires possibles. Il s'agit alors d'une causalité radicalement différente, libérée de toute analogie avec l'action de l'homme et des machines. Les forces en présence n'y interviennent que par les termes d'énergie correspondants placés dans le lagrangien, mais on sait cependant en déduire des valeurs de forces lorsque cela est nécessaire pour la prévision de mesures expérimentales. Or, si certaines forces mécaniques ou électromagnétiques se mesurent toujours avec les instruments traditionnels comme le ressort ou la balance coulombienne, il n'en est pas de même des forces nucléaires ni des forces astronomiques. Celles-ci ne peuvent relever de mesures directes, mais des détections de particules dans les accélérateurs ou des mesures de position des corps célestes. On ne continue alors à parler de forces que par analogie avec le domaine de nos dimensions terrestres.

Une solution de nature différente a été mise en place en 1915 par Einstein grâce à la théorie de la relativité générale. Le corps qui tourne autour du Soleil ou d'un astre quelconque n'est soumis ni à une force centrifuge ni à une force centripète, mais suit simplement le plus court chemin dans un espace courbé par l'action du corps central. On parlera à nouveau de forces dès que le corps sera dévié de son parcours sur la ligne la plus courte de l'espace courbé, par interaction électromagnétique ou nucléaire. Les tentatives d'unification de la gravitation avec les autres forces englobent également l'ensemble des modifications géométriques des forces de dimensions supérieures.

La physique cherche donc aujourd'hui sa voie dans un éventail assez large de traitement de la causalité. La force, point particulier de ce vaste domaine, demeure cependant pour notre intuition la « cause » par excellence, même si elle n'est plus du tout le concept central de la physique contemporaine.